Mise à jour le 29 Décembre 2025

🚗 Présentation de l’ensemble des logiciels FELLY-SOFTWARE

L’écosystème FELLY regroupe un ensemble de modules logiciels dédiés à la conduite autonome, chacun ayant un rôle bien défini dans la chaîne de perception, de décision et d’action du véhicule.

Tous ces modules sont interconnectés par le réseau, permettant une exécution :

- soit sur un seul et même ordinateur,

- soit distribuée sur plusieurs machines pour répartir la charge et les rôles (PERCEPTION, DECISION, ACTION, etc.).

💡 Parenthèse technique

Le développement de ces logiciels a été entièrement et volontairement réalisé sur des ordinateurs d’anciennes générations, tels que le Lenovo B590 (2016). Cette approche vise à optimiser le code et les performances logicielles avant toute amélioration matérielle, garantissant une robustesse et une efficacité maximales sur des ressources limitées.

1 . Le module PERCEPTION 3D

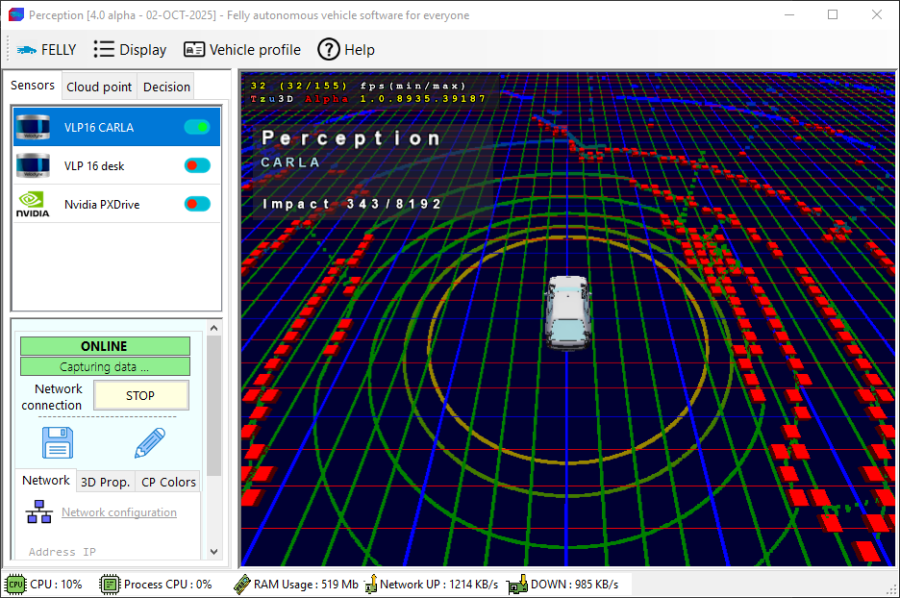

Exécution de perception v4 sur Carla Simulator

Perception 3D est un logiciel entièrement développé en C# (et C++ pour les drivers), fonctionnant à la fois sur CPU et GPU.

Considéré comme un gestionnaire multi-capteurs (caméras, lidars, sonars, radars...) et assure cinq fonctions principales :

- Association et configuration simplifiées des capteurs.

- Gestion du cycle de vie des capteurs : démarrage, arrêt, redémarrage et débogage/avertissements

- Positionnement, redimensionnement et projection des nuages de points à chaud issus de chaque capteur.

- Fusion et génération d’obstacles formels représentés sous forme de petits cubes.

- Transmission des données vers les autres modules du système.

Le module a pour objectif de fusionner l’ensemble des perceptions des capteurs en tenant compte de leur position et orientation physique réel --> fidèle dans une représentation 3D, afin de produire un nuage de points colorisé en temps réel, relatif à l’orientation du véhicule.

En fonctionnement comme à l’arrêt, il est possible de positionner, orienter, focaliser, ajuster la densité et découper (cropper) la projection du nuage de points de chaque capteur.

Comme indiqué précédemment, PERCEPTION 3D a également pour rôle de segmenter et résumer les obstacles détectés sous forme de cubes rouges, avant de transmettre ces informations au module DECISION.

Capteurs supportés

- Velodyne VLP16

- Ouster OS1

- Valeo / IBEO SCALA

- Intel RealSense D435 / D455

- Kinect Xbox 360

La projection virtuelle de perception utilise la technologie DirectX via Tzu3D, développé par Wahid GARCI. FAQ : Pourquoi Tzu ?

2. Le module VISION

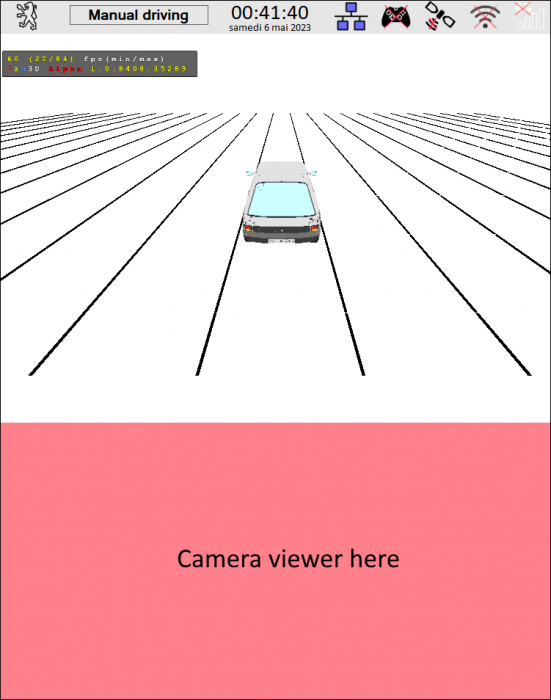

Aperçu sur Carla Simulator

Le module VISION V2, développé entièrement en C++ à partir du SDK NVIDIA PXDrive 2 (DriveWorks 1.2), vient en complément du module PERCEPTION. Il a pour rôle de segmenter la route en identifiant les bordures, les lignes au sol, la signalisation, ainsi que les obstacles présents dans l’environnement.

Bien que DECISION est capable de fonctionner sans ce dernier, il s’intègre à chaud au module DECISION lorsqu’il dispose de données exploitables, permettant ainsi d’enrichir les informations de perception et d’affiner la trajectoire générée.

2 . Le module DÉCISION

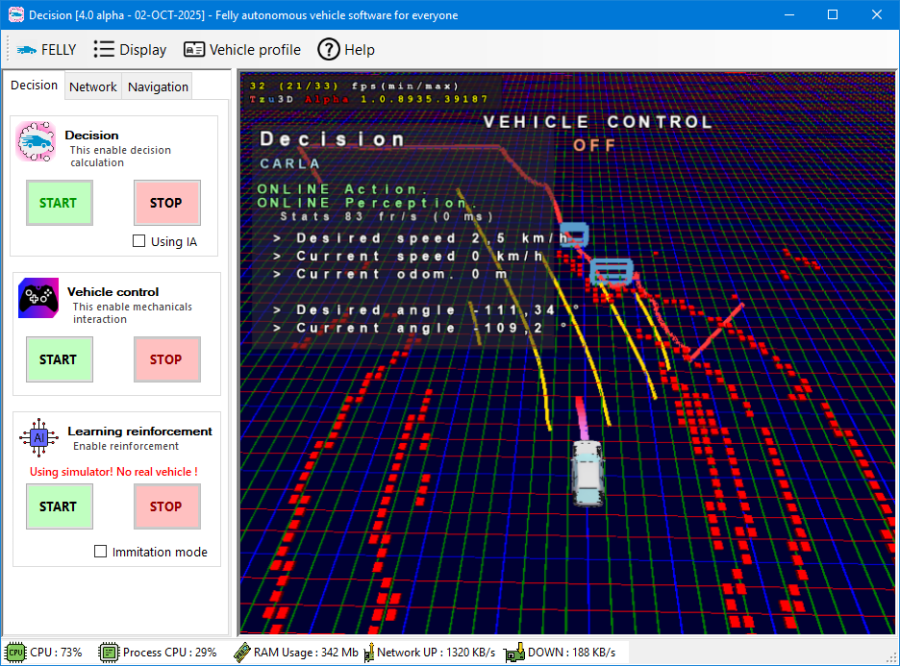

Le module DECISION reçoit en entrée les données d’obstacles issues du module PERCEPTION, afin de calculer en temps réel une trajectoire de conduite (angle de braquage et vitesse en km/h).

Lorsque les informations du module VISION sont disponibles, (provenant du système NVIDIA DRIVE) alors DECISION reconstruit une représentation 3D complète de l’environnement (image ci-dessus). Celle-ci inclut notamment les marquages au sol, la lecture des panneaux, les bordures de chaussée ainsi que l’identification des obstacles détectés. La classification des obstacles permet d’adapter plus finement le comportement du véhicule. De leur côté, les lignes au sol et la signalisation servent à mieux contraindre la trajectoire du véhicule vis-à-vis du code de la route (respect des voies, priorités, limitations, etc.).

Décision fonctionne sous 2 modes

-

Navigation libre : Tel qu'une Tesla sur route!,

généralement pour des expérimentations car elle a tendance à "fuir" n'importe où sans règles... -

Navigation PathTracer : Via une cartographie, beaucoup plus sécurisé et fiable. (image ci-dessous)

Fonctionnalité privilégié dans le cadre de démonstrations / exploitations -

Navigation par IA / Apprentissage : Via un modèle ONNX, permettant d'apprendre à conduire.

Pas fiable pour le moment. Pour expérimentations seulement.

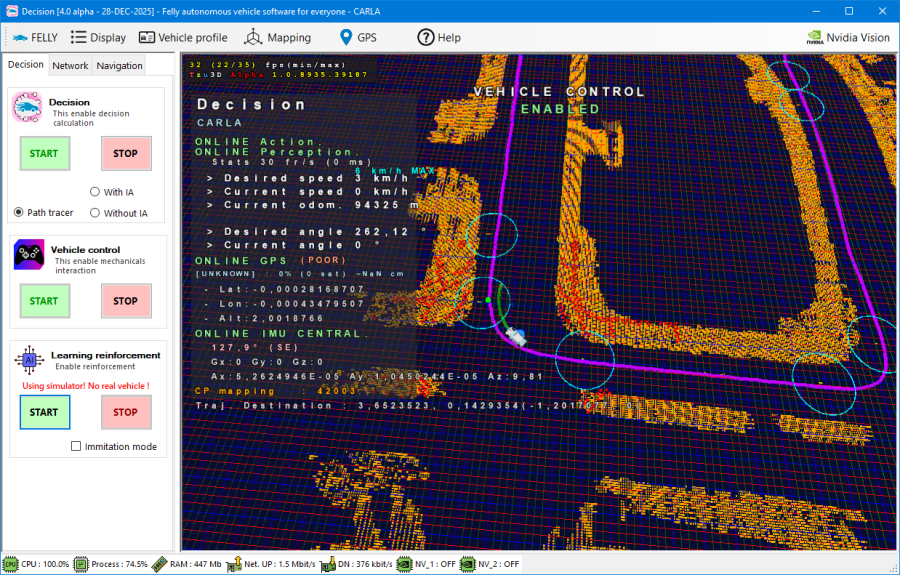

Nouveau mode : Navigation PathTracer (via cartographie)

Un nouveau mode est apparu entre novembre et décembre 2025 : l’utilisation d’une cartographie pré-construite.

Grâce à un outil nommé Felly PathTracer, le système récupère les données de perception ainsi que les informations GPS / IMU, génère une cartographie de l’environnement, puis exporte celle-ci sous la forme :

- D’un fichier PNG codifié

- D’un fichier META contenant les informations GPS associées

Le fichier PNG est ensuite édité via un simple éditeur d’images.

Il permet de définir visuellement différentes règles :

- Zones orange : zones d’occupation

- Tracés violets : trajectoires recommandées

- Tracés blancs : zones interdites au franchissement

- Tracés bleus : trajectoires alternatives

- Cercles cyan : Zone de consignes de vitesse maximale

Ces éléments permettent de décrire précisément le comportement attendu du véhicule relatif à sa position : sens de circulation, trajectoire autorisée ou interdite, limitations de vitesse, etc.

Ce mode de navigation n’est pas récent et reste aujourd’hui largement exploité par les constructeurs spécialisés dans la conduite autonome en environnement fermé ou contraint, tels que Navya, EasyMile, Waymo, Cruise ou encore Baidu.

3 . Le module ACTION

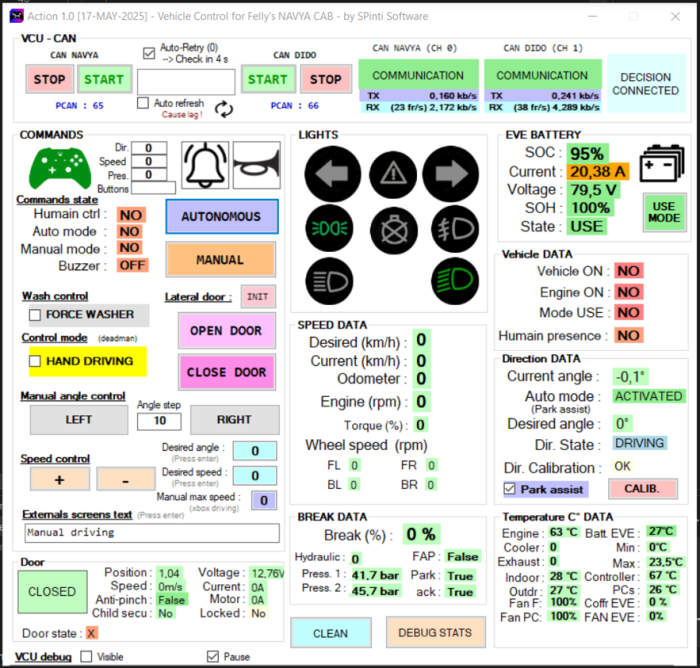

L'interface robotique du véhicule.

_Aperçu du module ACTION du Navya CAB

Le module ACTION, compatible avec la Peugeot 205, le Navya CAB ainsi que le simulateur CARLA, assure l’interface entre la décision logicielle et le pilotage physique du véhicule.

Il a pour rôle principal de :

- Prendre le contrôle du EVCU / VCU (Vehicle Control Unit) en envoyant des commandes de pilotage via CAN ou Ethernet

- Piloter les actionneurs du véhicule : direction, vitesse, freinage d’urgence, etc.

- Récupérer les données véhicule, notamment :

- position de la crémaillère de direction

- vitesse odométrique

- position des pédales

- températures moteur et huile

- puissance et consommation électrique

- état de la batterie (pour les véhicules électriques)

- Permettre un contrôle manuel du véhicule à l’aide d’une manette Xbox, principalement à des fins de test, de calibration et de validation

- Assurer la réception et l’application des consignes de conduite générées par le module DECISION

3 . Le module IHM

Ce module est l'interface graphique (plus accueillante!), adapté aux écrans tactile de bord, où il est possible de piloter le packaging complet de Felly et visualiser en temps réel les évènements

Il permet

- D'interagir avec l'ordinateur de bord à travers de menu sobres pour l'utilisateur.

- Afficher au premier écran, un rendu 3D bref de l'environnement représentant les obstacles autour du véhicule ainsi que sa trajectoire.

- Afficher un visuel des caméras.

- Monitorer le système informatique, redémarrer des modules.

- Démarrer le mode autonome. Choisir une destination

- Afficher manuellement des messages sur les affichages

Français

Français

English

English